(1)简介

图灵实验在人们不知情的情况下,用智能系统模拟人类行为。一般认为,人们更倾向于信任与人的合作,而不愿意与智能机器、系统与算法等合作。例如传统的类似网络营销电话,通常是采用机器模拟语音来进行,隐藏智能机器的属性,这会导致人类产生欺骗、恐惧的体验,同时产生道德伦理方面的巨大挑战。本研究的目标是探索如下的问题:如果确实告知了机器作为合作伙伴,让人类拥有良好的透明度,会不会降低人机系统的效能。

(2)方法与过程

本研究基于伊索沃-奥洛克(F.Ishowo-Oloko)等人2019年的相关研究,在中国大陆地区开展比较研究。在智能机器算法层面,选取伊索沃-奥洛克相同的算法软件S++,并对其提供给被试的用户界面进行中文化处理。在此基础上,利用算法对人与人合作以及人与智能算法合作的情形进行实验研究。

实验采用2×2实验配比,如表1。实验随机招募219人,分别被随机分配到下表的四个条件之一。

| 实际情况 | 告知情况 | |

| 与人合作 | A1(真实告知)与人合作 | A2(错误告知)与机器合作 |

| 与机器合作 | B1(错误告知)与人合作 | B2(真实告知)与机器合作 |

研究使用“是否完成合作(完成合作的比例)”和“完成合作的时间”作为人机系统效率的指标。实验中的相关游戏共进行40轮,考察人机合作过程四个不同情境对结果的影响。

(3)结果

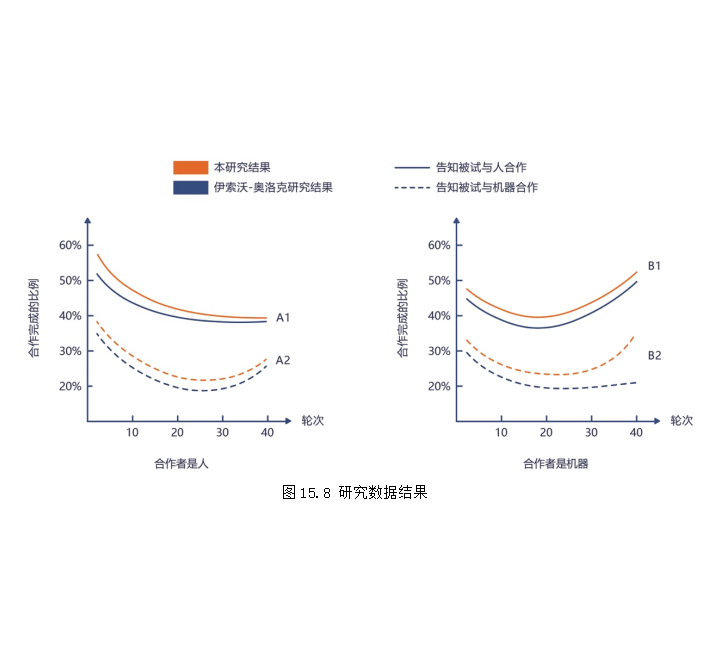

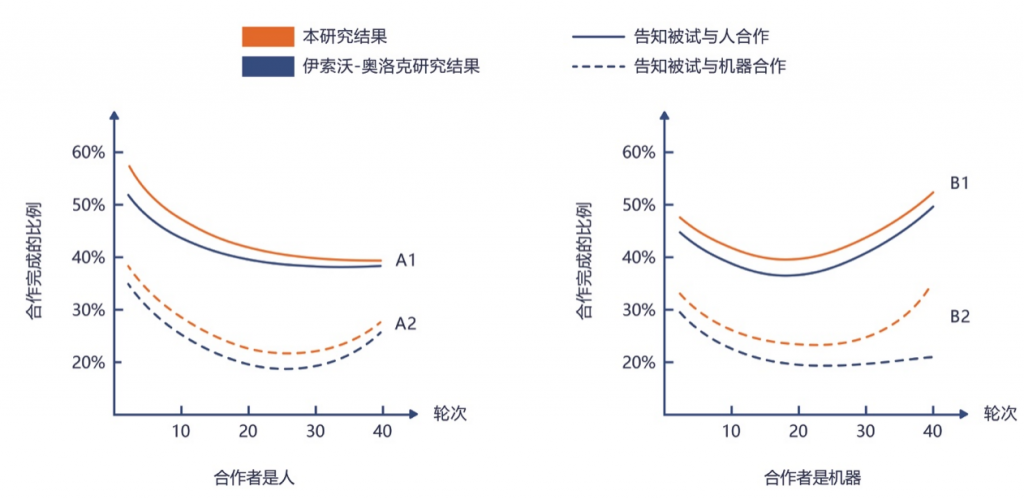

图1是实验40轮游戏后完成合作的比例的情况。图中的橙色线条是本研究的结果,蓝色线条是伊索沃-奥洛克2019年研究结果的拟合。

从图中可以明显看出,告知被试与人合作(不论是真实还是错误,A1、B1),完成任务的比例高于告知被试与机器合作(A2、B2)。从统计的结果来看,该模型中告知被试的合作类型存在显著性差异(z =3.129,P<0.001)。同时,不同的轮次(z =-7.911,P<0.001)以及不同轮次与真实合作的情况的交叉效应(z =-7.109,P<0.001)也存在显著性差异。

进一步的分析和比较可以发现,当机器人被当作人告知用户的时候(B1),其效能高于与真实的人进行合作;但是一旦告知是与机器合作(B2),其效能下降大约10-15%水平,但是这两个水平仍然高于把真实人类行为看作机器(B1)。更加通俗的说法是:“机器伪装成人”是效能最好的,告知用户是真实的机器以及真实的人合作,效能变化不大。但是把真实人的合作讲成和机器合作,是效能最低的。这个结论与伊索沃-奥洛克的相关研究基本一致。

另外,本研究还发现:随着合作轮次的变化,合作完成的比例呈现下降趋势,但是到了20-30次合作左右的时候,随着磨合的增加,合作完成的情况也会出现一个改善。这个趋势与合作对象或者告知的对象关系不大。然而,伊索沃-奥洛克的研究中,当合作者是机器并告知与机器合作(B2)的时候,并没有出现这种磨合增加的效应。这初步反映了两个研究中不同背景的被试在与智能机器合作效能上可能的细微差异。

从完成任务的时间来看,其研究结论与前面的任务完成率相似(如表2),进而验证了上述研究结论。

| 实际情况 | 告知情况 | |

| 与人合作 | 15.7s(A1) | 27.0s(A2) |

| 与机器合作 | 17.9s(B1) | 26.3s(B2) |

4)讨论

本研究的结论初步表明,智能机器的透明度可能会损害性能。然而,公众总体期望智能机器是透明的,本书第18章的可解释人工智能将会继续讨论这个问题。但是,从人角度来看,人是否一直会对机器保持透明,也是一个非常有挑战的话题。事实上,人类自身也没有做到完全透明。因此,从哲学的角度看,机器没有必要一定要对人保持透明。

上述讨论引出了一个更深层次的问题,即是否应该为了效率而允许机器隐藏其“非人”的属性。归根结底,这种选择必须由与这些智能机器发生交互关系的人来决定,否则将可能违反社会技术体系中人类自主、尊重和尊严的基本价值观。然而,如果人们知道透明情况下人机系统的效能可能因为透明而受到损害,也许人们可能会认为机器不透明是可以接受的。当然,这种策略是否“在道德上是有根据的”、“在社会上是否可以接受的”,还有待观察。总的来说,通过不透明的机器行为来追求效率很可能与其他价值观相冲突,但是从效能的角度,也许人们会接受或者部分接受与智能机器展开合作。因此,设计师需要在机器完全透明与成本之间寻求平衡,以最大限度发挥智能机器的作用。