(1)背景与目标

2018年和2019年,美国麻省理工学院拉万(I. Rahwan)等连续发表了《自动驾驶汽车道德困境》和《道德机器实验》两篇论文,在全球范围内开展了自动驾驶汽车道德困境的大样本问卷研究,试图从了解并尝试解决在自动驾驶汽车的道德困境问题。本研究基于上述研究,在汽车车身先进设计制造国家重点实验室自主课题的资助下,在中国大陆地区开展出现类似道德困境的情况下人们的道德偏好,比较中国公众在道德困境上与全球公众的独特之处。

(2)方法与过程

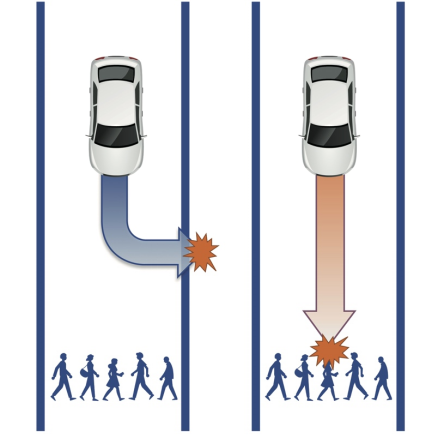

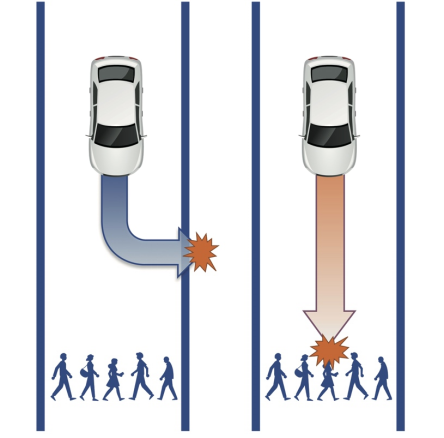

本研究主要采用在线问卷的方法。本文所涉及的道德困境基于如下图情境:

本图基于麻省理工学院邦立峰(J. F. Bonnefon)等人的研究来重新绘制。

图1表明了自动驾驶汽车发生不可避免的伤害事故时候面临的道德决策困境。左图说明自动汽车左转,牺牲自动驾驶汽车的乘员而保护行人,右图说明自动汽车直行,保护自动驾驶汽车的乘员而牺牲行人。

首先,本研究注重情境在研究中的作用。因为用户在情境下回答问题与用户直接通过题目回答问题可能存在着决策的差异。本研究情境构建的方法,基于湖南大学在2006年完成的情境设计理论以及2012年完成的国家自然科学基金情境计算研究的成果,为每个被试提供一个自动驾驶的道德困境的情境,分为三类:自己独自一人,与同事一起、与家人一起。例如“与家人一起”的情境的示例如下:

“你和3名家人(配偶和2个孩子)在汽车里沿着一座桥上的主干道行驶。突然,8名行人出现在汽车的直接路径前面。如果汽车转向路边,它会坠入河中,杀死你和你的家人,但让行人安然无恙。如果汽车留在你目前的路径上,它会杀死8名行人,但你和你的家人将安然无恙。”

其次,研究采用101点的量表(0-100),并通过滑动条的方式,让用户在”直接开,挽救你和你的家庭成员,但杀死8名行人”和”转向,挽救10名行人,但杀死你和你的家庭成员”之间,通过自己的选择来表达自己的选择以及不确定性。每个问题都以”根本不可能 (0)”和 “极有可能 (100)” 为基础。

本研究通过在线问卷的方法,在国内某商业市场研究网站执行。研究共有534名被访问者参加,其中有效被访问者为511名。研究人员随机分配了调查问卷的不同情境。除了主要的问题外,研究还包含部分人口统计学问题,例如性别、年龄、教育和收入水平等。

(3)研究结果

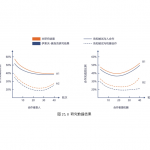

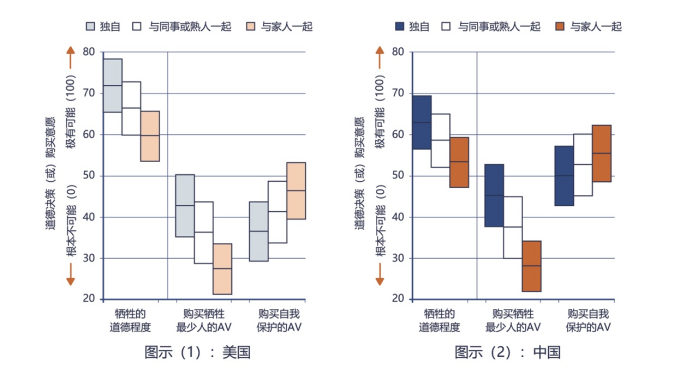

本研究的主要结果如下图所示:

左图为邦立峰等人的研究结果,右图为本研究的结果。图中的每个框的中心线表明均值,框的上下范围表明了95%的置信区间。

从图中可以看出,不同的情境会产生完全不同的道德决策。在“选择牺牲自己保护行人”这个倾向于牺牲自己的选择时候,与自己的家人在一起的意愿最低,与同事在一起其次,独自一人意愿最高。而“是否需要购买主动保护措施”或者“购买最少的自我保护系统”这两个答案也相似,即与家人在一起更倾向于保护自己。

从中美两国的对比数据来看,总体研究结果非常相似,特别是面临不同的道德困境上的差异,几乎完全相同。从图中两个研究的差异来看,我们只能初步推断:中国公众购买自我保护的自动驾驶汽车的倾向高于美国。但是这样的差异只是描述性的,因为两个研究在结构上有显著不同,因此,比较研究只能基于描述性对比层面。

研究还对人口统计学因素对相关结果的影响进行了分析,其相关结果如表1所示:

| 道德 | 差异 | |

| 性别 | 5.394***(0.636) | 1.346**(0.433) |

| 年龄 | 0.207***(0.024) | 0.150***(0.016) |

| 教育 | 1.871**(0.620) | 2.300***(0.422) |

| 收入 | 1.554***(0.441) | 1.332***(0.300) |

从分析可以看出,人口统计学的各个因素——性别、年龄、教育和收入水平都可能影响人们的道德偏好。这与美国的相关研究也基本一致,只是在统计数值上略有差异。

(4)讨论

对于自动驾驶汽车而言,道德困境似乎是难以解决——但是又必须解决的问题。本研究发现,如果道德困境出现,那些对社会“不道德”的自动驾驶汽车可能会占据主要的市场,因为大家倾向于保护自己于家人。针对这样的问题,一种可能解决方案是:把自动驾驶汽车乘员受伤或者死亡的风险转移到完全减少事故的发生率的基础上。但是仔细探究这个问题,似乎则会出现两种悖论的情形:一种是,随着驾驶安全性的提升,人们应该可以更倾向于拯救行人——使自动驾驶汽车更加“道德”。另外一种是,随着安全性的提升,人们觉得主动安全的自动驾驶汽车更加可信,人们出现事故的可能性将更小——但是这会带来道德困境将更加严重。

本研究并没有找到解决自动驾驶汽车道德困境的方法。如果可以在概念层面建立解决道德困境的理想机器行为,从本研究的角度看,代码和算法可以输出一个“结果(解)”。但是,关于这些结果的影响,本研究尚无法进行估计。除了与各类道德困境研究相似的局限性以外,本研究只对一个抽象情境进行了分析,而道德决策的复杂性使得研究者难以穷举所有的情境,即使拉万等人的研究已经达到数千万回答,这样的问题也没有能够解决。因此,这样的问题除了在设计、科学和工程领域进行讨论外,加入法律责任、政府管理等治理机构的实践与尝试,也许更为有效。但是,机器行为的道德偏好研究还是需要进行下去,直到完美的道德决策的机器行为,它总是可以完美地拯救行人与乘客。